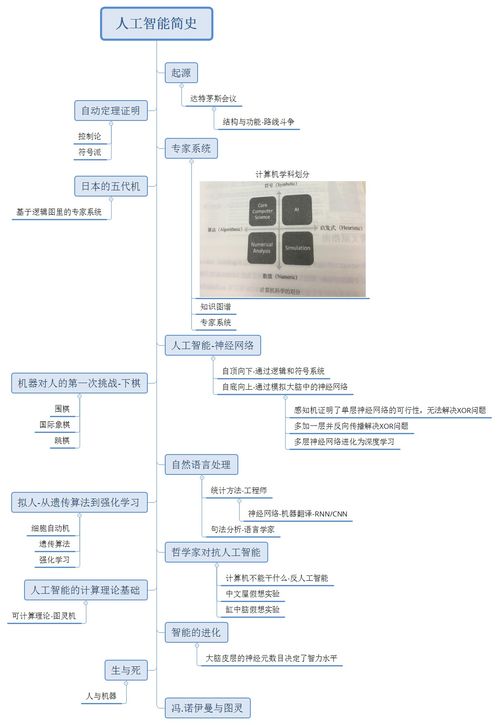

人工智能简史与基础软件开发 一份阅读笔记脑图

引言:智能的追寻

人工智能(AI)的简史,是一部人类将思想与技术交织,追寻、模拟乃至拓展自身智能的壮丽史诗。从最初的哲学思辨,到如今的深度学习浪潮,AI的发展并非一蹴而就。对于从事AI基础软件开发的工程师而言,理解这段历史,不仅是知识的积累,更是洞察技术脉络、把握未来方向的罗盘。本文将以一份“阅读笔记脑图”的形式,梳理AI发展的关键节点,并探讨其与当下基础软件开发实践的深刻联系。

第一部分:人工智能简史脑图脉络

1. 奠基与幻想(1950s前)

思想源流:古希腊神话中的自动机械,莱布尼茨的“通用演算”,图灵的“模仿游戏”(图灵测试,1950)。

关键事件:1956年达特茅斯会议,“人工智能”一词正式诞生,乐观主义弥漫。

* 软件开发启示:确立了AI的根本目标——让机器执行需要智能的任务。基础软件开始关注符号表示与逻辑推理。

2. 黄金与寒冬(1960s-1970s)

符号主义兴盛:专家系统(如DENDRAL)成功解决特定领域问题,Lisp语言成为AI开发主力。

面临瓶颈:“组合爆炸”问题凸显,知识获取困难,算力与数据不足。

* 软件开发启示:强调了领域知识与推理引擎分离的架构价值,同时也暴露了纯符号方法处理不确定性和学习能力的局限。

3. 复兴与分化(1980s-1990s)

连接主义回归:反向传播算法重新点燃神经网络研究,Hopfield网络、BP网络出现。

新范式涌现:统计学习方法兴起,支持向量机(SVM)表现优异。

* 软件开发启示:软件架构需支持数值计算与迭代优化。算法库(如LINPACK)和专用硬件(尽管当时有限)的重要性初显。

4. 数据驱动的崛起(2000s)

互联网与数据:海量数据成为新燃料。

机器学习主流化:以SVM、随机森林为代表的实用算法在工业界广泛应用。

* 软件开发启示:大规模数据处理框架(如Hadoop)和通用机器学习库(如Scikit-learn)成为基础设施的关键部分。软件工程中的可扩展性和效率问题凸显。

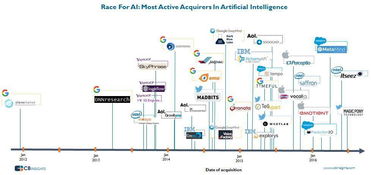

5. 深度学习的浪潮(2010s至今)

突破性事件:AlexNet在2012年ImageNet竞赛中大获全胜,GPU算力、大数据与算法改进形成完美风暴。

全面渗透:CNN、RNN、Transformer等架构在视觉、语音、自然语言处理等领域取得革命性进展。生成式AI(如GPT、DALL-E)引发新热潮。

* 软件开发启示:基础软件栈发生巨变。深度学习框架(TensorFlow, PyTorch)成为核心生产工具,模型部署、监控、持续训练(MLOps)成为新的工程挑战。算力抽象(CUDA,以及更上层的编译器如TVM)和模型服务化是关键。

第二部分:人工智能基础软件开发的当代核心

从历史脑图中可以清晰地看到,AI基础软件开发的重心,已从早期的符号逻辑引擎,演变为今天支撑数据驱动和深度学习的复杂技术栈。其核心层次包括:

- 计算层:提供底层算力(GPU/TPU/专用AI芯片)及高效的并行计算编程模型(如CUDA)和编译器(如MLIR,Apache TVM)。这是性能的基石。

- 框架层:提供灵活、高效的模型定义、训练和推理接口(PyTorch的动态图、TensorFlow的静态图与即时执行)。它们是AI研发的“操作系统”。

- 模型与算法层:封装各类预训练模型、经典算法,并通过模型仓库(如Hugging Face Model Hub)促进共享和复用。

- 工具与平台层(MLOps):覆盖从数据管理、特征工程、模型训练、评估、部署、监控到持续迭代的全生命周期管理(如MLflow, Kubeflow)。这是AI工程化、规模化的保障。

历史、现在与未来的交汇

回顾人工智能简史,每一次范式的变迁都深刻重塑了基础软件的形态。早期的逻辑推理催生了Lisp和Prolog,今天的深度学习则让PyTorch和TensorFlow成为明星。对于开发者而言,这份“脑图”提示我们:

- 理解本质:超越框架API,理解不同AI范式(符号、统计、连接)背后的思想,能帮助我们选择更根本的解决方案。

- 关注基础设施:最激动人心的创新往往建立在强大的基础软件之上。参与构建或精通这些基础设施(如新的编译器、分布式训练框架)具有极高价值。

- 拥抱工程化:AI的未来不仅是算法的突破,更是如何可靠、高效、规模化地将智能部署到现实世界的工程问题。MLOps能力正变得与模型研发能力同等重要。

人工智能的简史仍在快速书写,其基础软件开发也日新月异。以史为鉴,我们不仅能更好地驾驭当下的工具,更能敏锐地感知下一次范式转换的曙光,并为构建下一代AI基础设施做好准备。

如若转载,请注明出处:http://www.huiganjiang.com/product/58.html

更新时间:2026-02-24 12:53:35